Mit Fabric Daten zurückschreiben über Power BI! 17.01.2025

...das wollen alle: im Power BI-Bericht, dort, wo sie ihre Zahlen analysieren, einfach mal ein paar neue Werte eintippen können, speichern, fertig. Ja, das ist keine ordentliche Finanzplanung mit Splashing und Genehmigungs-Workflow, aber reicht für kleine Anforderungen wirklich, und kommt genau so vom Hersteller! Dieses Video zeigt das in der Praxis, und welche Neuigkeiten es in Fabric und Power BI gebraucht hat, damit das jetzt funktioniert.

Jetzt jede Datenbank nach Microsoft Fabric spiegeln: mit Open Mirroring! 10.01.2025

ETL war gestern, heute ist: Datenbankspiegelung in den Fabric OneLake! Mit ein paar Klicks ist das eingerichtet, dass die gewünschten Tabellen meiner Datenquelle im OneLake zur Verfügung stehen, und alle Änderungen danach werden sofort inkrementell übertragen. Genial, oder? Leider noch nicht für alle Datenbanken verfügbar. Aber bestimmt bald, denn Microsoft hat "Open Mirroring" released, und das macht diese Spiegelung so einfach, dass man es mit Excel oder Notepad selber machen könnte! Also: baut Euch die Anbindung für Eure Lieblingsdatenbank selber, oder wartet nur kurz auf den Dritthersteller, der das machen wird. In dieser Demo mache ich das allerdings wirklich mit dem Texteditor...

Fabric AI Skills: Datenintegration mit ein paar dummen Fragen 03.01.2025

Wir machen Fabric vor allem, um in unserem OneLake saubere und integrierte Daten für KI-Lösungen zu bekommen. Aber wie sehen diese Anwendungen dann aus? Auf der Ignite-Konferenz Ende 2024 hat Microsoft das erstmalig durchblicken lassen: die Fabric AI Skills (auf deutsch heißen die allen Ernstes "KI-Fähigkeiten") ermöglichen es jedem Nutzer, einfach doofe Fragen (derzeit nur auf Englisch) an seinen Datenbestand zu stellen. Und der antwortet einfach so, egal, ob Lakehouse, Warehouse, KQL-Datenbank oder semantisches Modell! Chatte mit Deinen Daten, aber richtig! Unglaublich? Seht selbst...

Copilot für SQL Server 29.11.2024

SQL Server-Urgesteine unter sich: Steffen Krause trifft Markus Raatz auf der SQLdays-Konferenz 2024 in München, und sie reden über Copiloten für SQL. Welche eignen sich für Entwickler, aber auch für Endanwender? Beim SQL-Schreiben bekommt man jetzt überall Hilfe angeboten, zum Beispiel im Github Copilot und im Azure Portal, im Azure Data Studio oder - ganz neu - sogar im SQL Server Management Studio. Und Steffen und Markus diskutieren darüber, ob ein Endanwender jetzt noch SQL lernen muss oder nicht!

Plan/Ist-Vergleiche in Power BI und Fabric richtig modellieren 22.11.2024

In Power BI geht ne Menge, in Fabric geht noch mehr, aber nichts geht ohne die richtige Modellierung der Daten, für die es auch noch keine KI gibt! Ein klassisches Problem dabei: Ist-Daten sind auf Tagesebene, Plandaten auf Monatsebene. Das passt schlecht in ein und dieselbe Tabelle! Und wie richtet man dann die Beziehungen zwischen mehreren Tabellen ein? Zu dem Thema habe ich ja schon zwei Videos gemacht, aber es finden sich immer wieder neue Lösungen, diesmal eine mit der Formelsprache DAX. Danke an Vladimir Stepa von diacom für die Anregung!

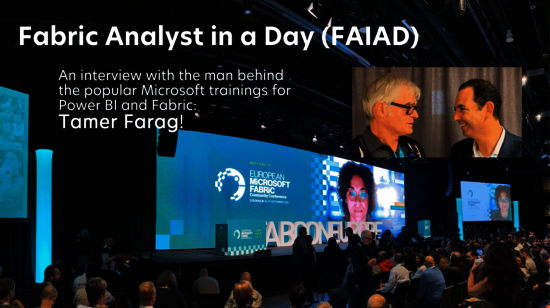

"Dashboard in a Day" and "Fabric Analyst in a Day" trainings: who invented this? 15.11.2024

Power BI has changed Microsoft forever. The way this tool was developed, the agility and speed, the use of the community were completely new. And the way you learn new software has also changed since then, namely with “in a Day” training courses such as “Dashboard in a Day” or now “Fabric Analyst in a Day”, which Microsoft partners hold on a standardized basis and en masse for interested parties. The man behind these trainings is Tamer Farag, and I met him at FabConEurope in Stockholm and pulled him aside for a quick chat!

Ladevorgänge automatisiert erzeugen in Fabric? Interview mit Ben Weissman 01.11.2024

Ben Weissman, sehr wichtig und beliebt in vielen Daten-Communities im Microsoft-Umfeld, traf sich mit mir im Separée am Rande der SQL Konferenz in Hanau, und wir haben natürlich über eins seiner vielen Lieblingsthemen, über BIML, gesprochen, aber um vieles anderes mehr: die Entwicklung bei Fabric, was noch on premise passiert und woher er die schicksten T-Shirts bekommt (und dabei haben wir noch nicht mal von Brillen angefangen!). Fazit: Metadaten-basierte Ladevorgänge, automatisch erzeugt, sind alles andere als tot.

Endlich: Self-Service KI in Fabric auf meinen Datein, mit AI Skills! 25.10.2024

Die neuen AI Skills (auf deutsch heißen sie wirklich: "KI-Fähigkeiten") von Microsoft Fabric machen endlich einmal klar, wozu wir uns überhaupt die ganze Mühe mit dem Fabric OneLake machen: damit wir saubere Daten für die künstliche Intelligenz haben! Und mit AI Skills kann auch der Fachanwender mit seinen Daten chatten und echte Erkenntnisse aus ihnen ziehen, ohne SQL-Kenntnisse und ohne die Datenstruktur näher kennen zu müssen. Alles, was es braucht, sind sprechende Tabellen- und Spaltennamen, aber das habt Ihr doch, oder? Den fertigen "Daten-Chatbot" kann man dann einzeln in Teams oder im Browser publizieren, oder sogar in eigene Chatbots im Copilot Studio einsetzen. Nach diesem Video werdet Ihr auch sagen: es hat sich gelohnt!

Adam Saxton from "Guy In A Cube" on how fast Fabric is developing 18.10.2024

I met Adam Saxton, the ever-popular “Guy In A Cube,” along with Patrick Leblanc, in person at SQL Konferenz 2024 in Hanau. We discussed the rapid development of Fabric and how to keep up with it. It was amazing and reassuring to hear someone from the Microsoft Customer Advisory Team (CAT) openly admit that even Patrick and he don’t know everything, and to learn how they handle the fast pace at which the Fabric product team releases new features! Since the interview was in English, this video and description are also in English, but my German viewers are invited to turn on subtitles ;-)

Data Governance mit Microsoft Purview, mit Wolfgang Strasser 11.10.2024

Wen kann man besser zur Data Governance auf der Microsoft - Plattform befragen als Wolfgang Strasser? Genau das habe ich kurz getan, auf der SQL Konferenz 2024 in Hanau, bei den Datamonstern! Wir lassen auch die neuesten Neuigkeiten von unserem gemeinsamen Besuch auf der #fabconeurope in der Woche davor einfließen. Dabei kommt auch zur Sprache, welche Teile von Purview schon in Fabric enthalten sind, und was man mit der kostenlosen Version von Purview erreichen kann!

Fabric und Notebooks, live von der FabCon Stockholm 2024! 27.09.2024

Herbstzeit ist Konferenzen-Zeit! Auf der Microsoft Fabric-Konferenz in Stockholm traf ich, direkt nach ihrem Vortrag, die deutschen Sprecher Oliver Engels und Tillmann Eitelberg und befragte sie zu ihrem Thema "Notebooks in Microsoft Fabric". Das ist doch eigentlich eine Entwickler-Technologie und nichts für Self-Service-Anwender, oder? Aber dazu haben sie natürlich eine sehr eigene Meinung. Viele Fragen musste ich jedenfalls nicht stellen, seht selbst!

Analysiert der Copilot für Excel jetzt meine Daten für mich? 06.09.2024

Eigentlich ist ja Excel immer noch das Schweizer Messer zur Datenanalyse, und das wird es natürlich auch bleiben. Wenn jetzt der Copilot für Excel für mich meine Daten verstehen und mir erklären und darstellen könnte, wäre das nicht fantastisch? Manche Demo-Videos, die im Netz kursieren, zeigen schon, wie eine KI so etwas macht, aber was kann der Copilot für Excel heute, im Jahre 2024, auf meinen Daten leisten? Dieses Demo-reiche Video zeigt es auf. Für alle, denen der Chef keine Copilot-Lizenz spendiert hat!

Fabric lernen? Jetzt mit Markus auf LinkedIn Learning! 16.08.2024

Ich habe es wieder getan: ein weiteres Videotraining, und diesmal fast zwei Stunden über das neue Microsoft Fabric. Dies ist das erste deutsche Training zu diesem Thema überhaupt, aufgeteilt in gut konsumierbare Video-Häppchen von ca. 5 Minuten Dauer, mit viel Hintergrund und Architektur, aber natürlich - ihr kennt mich - auch mit sehr viel Demo und "HowTo"! Hier seht ihr den Video-Trailer, der Rest ist auf LinkedIn unter /microsoft-fabric-ein-uberblick. Das Training ist für LinkedIn Premium-Mitglieder kostenlos, vielleicht ein Grund mehr, es zu werden? Ansonsten: wer mich per LinkedIn-Nachricht anschreibt, der bekommt einen Link von mir, unter dem er sich das Training 24h lang kostenlos betrachten kann. Viel Spaß dabei, und ich freue mich über Feedback!

Diktierfunktion? Mit Azure KI Services ganz einfach! 09.08.2024

Siri, Cortana, Dragon Dictate: wer keine Lust auf tippen hat, der erzählt das gerne einer elektronischen Diktierfunktion, und die ist wirklich erheblich besser, wenn eine KI das Ergebnis quasi permanent überprüft und verbessert! So etwas gibt es auch im Speech Studio von Azure AI Services, aber für den alltäglichen Einsatz geht es zusätzlich über eine voll altmodische aber auch voll praktische Kommandozeilen-Schnittstelle namens "spx"! Kommt mit zurück in die 80er, und ich zeige Euch die Macht der DOS-Batch-Programmierung!

PowerBI-Berichte in Echtzeit auf dem Bildschirm-dank PowerPoint! 19.07.2024

Eigentlich ein Klassiker: überall, wo Daten produziert werden, hängt daneben gerne ein Monitor mit Berichten drauf, und die möchte man natürlich automatisch aktualisiert haben! Power BI kann das, aber leider nur mit teuren Premium-Lizenzen und der automatischen Seitenaktualisierung (Automatic Page Refresh). Aber es gibt ja auch das Power BI Add-In für PowerPoint, und das kann Power BI-Berichte in PowerPoint-Folien einbauen. Diese Berichte können sich automatisch aktualisieren, wenn die Folien angezeigt werden, man kann Folien automatisch wechseln lassen, und schon läuft der preiswerte Produktionsmonitor! Ja, ja; Männer, die auf Linien starren.

Fabric OneLake Shortcuts zu lokalen Servern 05.07.2024

OneLake Shortcuts (oder deutsch: "Verknüpfungen") im neuen Microsoft Fabric sind genial, denn damit kann man sich Daten aus beliebigen Quellen so in seinen zentralen Data Lake holen, dass sie nicht kopiert werden, sondern immer in Echtzeit mit Zugriff auf die Quelle abgefragt werden: also kein aufwändiges ETL, keine doppelte Datenpflege, kein Lade-Projekt erforderlich. Und das geht sogar mit Daten, die noch "on premise" lokal in meinem Rechenzentrum liegen! Am besten haben die dann schon das Open Source-Format "Delta Parquet", aber das ist ja sowieso eins der besten Formate zum komprimierten Abspeichern großer Datenmengen. Unglaublich? Seht selbst!

Hier kommt Euer nächstes Geschäftsmodell: External Data Sharing in Microsoft Fabric! 21.06.2024

Sammelt Ihr auch Daten über Dinge, die Ihr für einen externen Kunden tut, so wie Pakete transportieren oder Einzelteile produzieren? Dann hab ich ne Idee: ihr gebt einfach die Daten für den externen Kunden frei, und der kann dann immer auf den aktuellen Stand zugreifen und sie selbst auswerten. Dafür müssen sie nicht extra kopiert werden! Das ist ihm sicher was wert. Dieses gute Geschäftsmodell (von wegen "Daten sind das neue Öl"...) geht jetzt auch in Microsoft Fabric, dank externer Datenfreigabe oder External Data Sharing über die Azure Tenants hinweg. Endlich, denn: mit Snowflake Data Sharing geht das schon lange... Was das mit der Rittern in Rüstung zu tun hat? Schaut selbst...

Daten, KI und Microsoft Fabric - Live-Diskussion über neueste Trends mit Michael Greth 14.06.2024

Für dieses Video habe ich mich mit SharePoint-Podcaster und Microsoft-MVP Michael Greth aka "Mike on AI" im Juni 2024 getroffen, um im Livestream über die Trends der Microsoft-Entwicklerkonferenz "Build" zu sprechen. Aber wenn wir da so sitzen, fangen wir sofort an zu diskutieren, zu analysieren und zu philosophieren, aus unseren vielen gemeinsamen Jahren im Microsoft-Ökosystem! Es geht in diesem Ausschnitt speziell über Daten für Künstliche Intelligenz, über Fabric und den OneLake, über Self Service Data Culture, über Change + Adoption und so weiter... Aber hört selbst!

Vergesst das Whiteboard - Fabric Aufgabenflüsse sind besser! 25.05.2024

Seit wenigen Wochen kann Microsoft Fabric etwas Neues: Task Flows, auf deutsch "Aufgabenflüsse". Das ist ein Feature, das die "Whiteboard Design Session" vom Projektanfang direkt in den Fabric Arbeitsbereich einbaut! Ist das genial, oder ist das albern? Dieses Video zeigt mehr, und erklärt auch, was man aus diesem Feature für Fabric-Architekturen allgemein lernen kann.

Endlich Intelligenz im Vertrieb: Copilot in Dynamics 365 Sales 10.05.2024

Copiloten poppen ja bei Microsoft-Produkten jetzt überall auf! Solche Spezialisten-Copiloten sind oft besser und praxisnäher als ChatGPT oder Microsoft 365 Copilot, weil sie von Anfang an die richtigen Daten für ihre Arbeit kennen. Ein gutes Beispiel dafür ist der Copilot in Dynamics 365 Sales, der eben auf meinen Daten über Kunden, Firmen, Kontakte, Leads und Verkaufschancen seine Intelligenz ausbreiten kann. In diesem demo-reichen Video zeigt und erklärt ihn mir mein lieber Kollege Niklas Hinke von der abtis Business Solutions aus Bremen!

Null ETL, Daten in Echtzeit: Mirroring in Fabric für SQL-Datenbanken! 05.04.2024

Ein großes Versprechen: mit Fabric wird alles einfacher, damit sich auch der Mittelstand moderne Datenauswertung leisten kann! Aber Microsoft liefert auch: mit dem neuen Mirroring in Fabric bekomme ich wirklich meine wichtigsten Quelltabellen ganz einfach in den OneLake in Fabric gespiegelt, und kann dann beliebig Abfragen darauf machen! Die Synchronisation läuft fast in Echtzeit, mit Change Data Capture, und dank dem neuen Direct Lake-Modus von Power BI sind die Abfragen darauf auch noch blitzschnell. Unglaublich? Kann man aber in diesem Video live in Funktion sehen, und auch noch ordentlich unter Last!

Die Quellen bleiben lokal, die Analysen in Microsoft Fabric 24.03.2024

„Ist ja toll, was Microsoft da schönes Neues mit Fabric in Azure anbietet, aber für mich ist das nichts, denn meine Datenquellen sind noch alle im Rechnerraum nebenan?“ Da gab es ja schon für Power BI oder die Power Platform eine gute Lösung: das lokale Datengateway. Und endlich, in seiner neuesten Version, unterstützt es auch das Laden von lokalen Daten in den OneLake von Microsoft Fabric! Und nicht nur mit Dataflows Gen2, sondern sogar mit Data Pipelines! Azure Data Factory, der „große Bruder“ der Data Pipelines, kann so etwas Tolles nicht… Ich zeige, wie einfach das jetzt funktioniert. Da werden in der Zukunft viele Architektur-Diagramme viel einfacher aussehen!

Excel als Datenquelle für Microsoft Fabric 15.03.2024

Da können wir Spezialisten auch noch so motivieren: Excel wird, gerade im Mittelstand, noch jahrelang eine wichtige Datenquelle für zentrale Data Analytics-Lösungen sein. In diesem Video zähle ich die Risiken davon auf, verspreche aber auch Linderung: Mit dem OneLake File Explorer werden lokale Excel-Sheets - wie bei OneDrive - sofort nach Änderungen in meinen OneLake synchronisiert. Und danach kann meine Fabric-Lösung über das "Lakehouse" darauf zugreifen und sie mit anderen Unternehmensdaten integrieren! Wie, das sehen wir uns Schritt für Schritt an.

Data Warehouse, Data Lake, Data Mesh und Fabric OneLake persönlich erklärt 26.01.2024

Dass ich in meinem letzten Video mal "im Bild" war, hat Euch scheinbar ganz gut gefallen! Also kommt hier noch etwas Besonderes: ein Interview mit Michael Greth von der SharePointCommunity (den man leider nicht sieht) zu den Grundbegriffen moderner Data-Lösungen in der Azure-Cloud: Data Lake, Data Warehouse, Lakehouse, Data Mesh... Was das ist, woher das kommt und wozu man das braucht erkläre ich persönlich (und wie immer sehr bewegt) in diesem kurzen und unterhaltsamen Video.

ChatGPT fragt Deine Datenbank 19.01.2024

ChatGPT "auf Deinen Daten", das kann ja mittlerweile fast jeder. Aber viele Daten liegen nicht als Texte oder PDFs vor, sondern sind nun mal in Datenbanken, die man mit SQL abfragen muss! Dieses Video zeigt eine einfache Lösung mit Power Apps-Frontend, die das so macht, dass der Anwender gar nicht merkt, dass er gerade SQL "geschrieben" hat! Und als Zusatzgeschenk kann ChatGPT dann plötzlich viel besser rechnen und vergleichen, als wenn er nur Texte als Input hat. Kleine Trigger-Warnung: Markus Raatz ist auch mal kurz persönlich im Bild zu sehen, um das erklären zu können!

Wozu einen multi-cloud Data Lake? 05.01.2024

Baut man seine Data Analytics-Lösung in der Cloud auf, muss man sich für einen Hyperscaler entscheiden, weil man dort in seinem Data Lake große Datenmengen ablegt, mit denen man schlecht wieder umziehen kann. Stimmt gar nicht! Wenn man das offene Format "Delta Parquet" nutzt, dann kann man mit Microsoft Fabric ganz leicht auf Daten zugreifen, die bei Amazon oder in der Google Cloud liegen, ohne dass sie dazu kopiert werden! Der Trick sind die Shortcuts oder Verknüpfungen, und die haben wirklich das Potenzial, multi-cloud-Lösungen viel, viel einfacher zu machen. In diesem Video kann man auch praktisch zuschauen, wie leicht man Dateien aus Amazon S3 Buckets in seinen Fabric OneLake einblenden kann!

Datenintegration ganz einfach mit Cut and Paste, dank Fabric OneLake 15.12.2023

Ich will eine neue Datenquelle in meine Data Analytics-Lösung einbinden? Da geht der Aufwand aber richtig los! Nicht so bei Microsoft Fabric, denn durch den OneLake als zentralen Data Lake unter allen Anwendungen kann Datenintegration so einfach sein wie Kopieren und Einfügen. Dieses Video zeigt mal an einem praktischen Beispiel, wie einfach auch ein Fachanwender seine Fabric-Lösung erweitern kann. Und man lernt dabei, was der Regen in New York mit dem Taxi-Verkehr zu tun hat!

Was mir der Fabric OneLake wirklich bringt 01.12.2023

Ist das noch Data Warehouse, oder schon Data Mesh? Dies ist ein etwas anderes Video als bisher, denn es geht nicht um technische Details, sondern ich stelle die Sinnfrage: wozu brauche ich dieses Feature? Welchen Nutzen haben wir davon? Ich beginne heute mit einem Data Lake, den man (fast) umsonst zu Microsoft Fabric dazubekommt: den OneLake. Klar, das Data Warehouse bleibt immer noch das non-plus-ultra. Aber hier steckt noch mehr drin: ein "Data Mesh"? Was ist das überhaupt, und: warum ist das auf der Welt?

Chatte mit deinen Daten 27.10.2023

ChatGPT auf meinen eigenen Daten: wer möchte das nicht? Einfach ein Chatbot, der meine Dokumente zusammenfasst, vergleicht, Fragen dazu beantwortet, in allen möglichen Sprachen fließend antwortet und datenschutz-kompatibel ist: ein Traum! Wie gut das auch mit Euren Daten klappt, könnt ihr super in Azure OpenAI Studio überprüfen, im Chat-Playground. Wir treffen uns auf dem Spielplatz!

Klonen und Zeitreisen leicht gemacht 03.11.2023

Ist das nicht pure Science Fiction? Aber nein: das Data Warehouse in Microsoft Fabric macht es schon heute möglich! Man kann z.B. Tabellen "klonen" und in einem Zustand aus der Vergangenheit "einfrieren", so dass Zeitreisen möglich werden. Und das alles als "Metadata Copy", also ohne die eigentlichen Daten zu kopieren, und daher blitzschnell! In der Realität ist das zwar fast unglaublich, aber vor allem eine Fähigkeit des Dateiformats Delta Parquet, das Fabric im OneLake benutzt. Und der populäre Marktbegleiter Snowflake kann es auch schon.

Der Data Activator in Microsoft Fabric 13.10.2023

Etwas wie Data Activator gab es bei Microsoft Data bisher nicht: ein Werkzeug, mit dem sich Fachanwender eine automatische Überwachung ihrer Kennzahlen einrichten können! Nie wieder morgens als erstes auf immer denselben Bericht glotzen... Und wenn eine ganz einfach selbst definierte Trigger-Bedingung erfüllt ist, dann chattet Data Activator mich in Teams an, oder er sendet den altmodischeren Kollegen einfach eine Email. Noch radikaler: er kann auch einen Power Automate Flow starten, der dann vielleicht gleich Maßnahmen durchführt, die die Zahlen wieder "auf die Schiene" bringen!

Was kann meine Microsoft Fabric-Kapazität? 29.09.2023

Bei Microsoft Fabric zahlt man keine Lizenzen, sondern - typisch SaaS - man kauft sich eine Kapazität in Azure, in der dann alle Operationen ablaufen. Und die kleinste Kapazität F2 bekommt man schon für 250 Euro im Monat! Und was schafft die so? Wann ist die "ausgelastet", so dass ich hochskalieren und mehr bezahlen muss? Und wer meiner Nutzer ist das gewesen? Dieses Video zeigt, wie man das mit der "Fabric capacity metrics"-App (auf deutsch sehr schön: Kapazitätsmetriken-App) überwachen kann.

Du kannst kein SQL? Kein Problem: das kann doch GitHub Copilot! 22.09.2023

Noch hat nicht jeder Microsoft Copilot in seinem Windows oder auf seinen Office-Daten, aber Entwickler kennen und schätzen schon den GitHub Copilot! Jetzt kann dieser nützliche Helfer auch die Abfragesprache SQL (in verschiedenen Dialekten), so dass man diese wichtige Fähigkeit als Entwickler schon gar nicht mehr braucht. Das geht erst mal nur im Azure Data Studio und ist auch kostenpflichtig (30 Tage Testlizenz), aber es ist verblüffend, wie gut diese KI mir die Statements vorschlägt! Allerdings braucht er dabei ein paar Tipps, und welche das sind, zeigt dieses Video.

ChatGPT auf Deinen Texten - ein Praxisbeispiel wird gezeigt 21.09.2023

ChatGPT kann auch ausschließlich Eure eigenen Dateien als Grundlage für seine Antworten verwenden, und das, ohne dass sie jemals zu OpenAI gelangen! Dafür ist unsere Lösung "Podcast Explorer", entwickelt zusammen mit der Abteilung Technisches Innovationsmanagement des Rundfunk Berlin-Brandenburg (rbb), ein wirklich schönes und unterhaltsames Beispiel. Podcast-Freunde gibt es ja schließlich Millionen in Deutschland, und in dieser Demo ist auch etwas für Sportangler dabei!

Frag ChatGPT, was in Deiner Datenbank steht! 08.09.2023

Du kannst kein SQL, möchtest aber wissen, was so in Deiner Datenbank steht? Vielleicht sogar mündlich und über das Ohr, also ohne das leidige Tippen? Kein Problem: die Kombination von Azure Cognitive Services Speech To Text und Azure OpenAI GPT-3.5 Turbo macht es möglich! Erstaunlich, mit wie wenigen Hinweisen ChatGPT lernt, was so in einer Datenbank zugeht, und sehr charmant, wie "er" mit einer freundlichen Frauenstimme geduldig meine Fragen beantwortet. Dabei generiert GPT sogar SQL-Joins und Subqueries! Seht selbst, oder diesmal eher: hört selbst, also: Lautsprecher an!

Bilder mit KI verstehen und klassifizieren: das kann Azure AI Custom Vision! 01.09.2023

Es ist überraschend einfach, eine KI zu trainieren und zu nutzen, die Gegenstände auf Bildern erkennt und dann in Kategorien einsortieren kann, damit so etwas kein Mensch mehr aufwändig tun muss! Dank Azure AI und der Komponente Custom Vision braucht man dazu keinen Data Scientist, sondern man kann es einfach mal ausprobieren. Wir haben das mal an einem Beispiel gemacht und zeigen in diesem Video, mit wie wenig Aufwand das zu absolut brauchbaren Ergebnissen führt! Und obendrauf gibt es noch eine Anregung, wie das dann mit einer App sehr leicht produktiv genommen werden kann.

Mein Computer spricht zu mir - mit Azure Cognitive Services Text-to-Speech 25.08.2023

Künstlich generierte Stimmen, die meinen eigenen Text vorlesen: das ist zwar sehr praktisch, aber oft hört es sich miserabel an. Azure Cognitive Services Text-to-Speech können das besser! In diesem Teaser-Demo-Video zeige ich, wie einfach man diese Funktionen bedienen, sich Texte vorlesen lassen und das Ergebnis integrieren kann, im Speech Studio. Und etwas hohe Literatur fürs Herz ist auch dabei!

AI? Kann eigentlich jeder, mit dem AI Builder aus der Power Platform! 18.08.2023

Es gibt nicht nur ChatGPT... Es gibt auch simple, praktische KI, die auf vorhandenen Daten ganz einfach die Zukunft vorhersagen kann! Und dafür braucht man auch kein Data Scientist zu sein, denn Microsoft hat das mit dem AI Builder in die Power Platform integriert und so leicht gemacht, dass es Fachanwender selber machen können. Zugegeben, der AI Builder kostet extra, auch wenn man schon Power Apps und Power Automate lizensiert hat, aber mal die kostenlose Testlaufzeit ausprobieren, das lohnt sich für jeden! Und mittlerweile kann er übrigens auch ChatGPT.

Azure OpenAI in Power Automate verwenden - ChatGPT checkt Mails! 04.08.2023

Wer Massen von Emails lesen, kategorisieren und beantworten muss, der wünscht sich oft einen Lektor, der ihm das abnehmen könnte! Das macht ja geradezu perfekt ChatGPT, und mit Azure OpenAI lässt sich diese KI ganz einfach und sicher kommerziell nutzen. Das geht sogar so einfach, dass es Fachanwender selbst machen können! Wir zeigen, wie so eine Lösung mit Hilfe von Power Automate aus der Microsoft Power Platform aussehen könnte. Power Automate ist eine "No Code - Low Code"- Umgebung, die oft in Microsoft Office schon enthalten ist! In unter 10 Minuten erfährt man in dieser Demo einer Kundenlösung, wie ChatGPT simpel und gerne dienstlich für uns arbeitet.

smapOne und Power BI - einfache Lösung mit Power Automate 21.07.2023

smapOne ist wirklich "No Code" - eine mobile Plattform, wo sich Fachanwender ganz einfach eigene Apps bauen und damit ihre Digitalisierung selber machen können! Aber wie bekommt man die so erfassten Daten dann in einem Power BI-Bericht angezeigt? In diesem Video stelle ich die komplette Lösung vor, mit REST-API, Power Automate und Dataverse. Das heißt: es bleibt immer noch "Low Code", und damit tauglich für den "Citizen Developer"! Und ihr seht Markus und Philipp live zu, wie sie die Anwendung im Dialog vorstellen. Endlich nicht nur einer, der da quatscht!

Demo: Ein komplettes Lakehouse in Microsoft Fabric "live" 14.07.2023

Das neue Microsoft Fabric wird die Art, wie man bei Microsoft in Zukunft Datenauswertung im Self Service machen kann, enorm erweitern! Da kommen Begriffe auf, die der Power BI - Nutzer bisher nicht kannte, was ist z.B. ein "Lakehouse"? Dieses Video zeigt als Demo "einmal durch", von den Datenquellen bis zum Power BI-Bericht, wie man so eine Lösung bauen könnte. Und das alles in unter 10 Minuten!

In Microsoft Fabric enthalten: ein Data Warehouse! 30.06.2023

SQL ist einfach nicht totzukriegen, wenn es um strukturierte Daten geht! Auch viele Power BI-Nutzer wünschen sich eigentlich eine SQL-Datenbank (die sollen sich mal Power BI Datamarts angucken), und beim neuen Microsoft Fabric wurde diese Bitte erhört. Neben dem sehr modernen "Lakehouse" enthält Fabric auch ein klassisches, massiv parallel aufgebautes SQL Warehouse, das jede Menge SQL-Funktionen unterstützt: nicht nur SELECT, auch UPDATE, INSERT und DELETE, zusammen mit gespeicherten Prozeduren und Funktionen. Wer SQL gut kann, säubert seine Daten einfach am schnellsten und am einfachsten mit SQL, und Microsoft Fabric gibt ihm das jetzt direkt in die Hand.

Mit Microsoft Fabric kann Power BI plötzlich Echtzeit, aber richtig! 23.06.2023

Wollt Ihr Echtzeitdaten auswerten, für IoT oder Logging-Analysen? Live, während sie ins System hineinlaufen? Das wäre früher ein Projekt komplett für die IT-Spezialisten gewesen, heute - dank dem neuen Microsoft Fabric - ist es auch vom interessierten Fachanwender zu bauen! Und da Power BI ja Teil von Fabric wird, kann man auch ganz leicht diejenigen Berichte machen, wo die Linien von alleine hoch und runter zappeln; nichts, was der Betrachter lieber sehen würde! Willkommen bei der KQL-Datenbank! In diesem Video wird nicht nur erklärt, wie es geht, wir zeigen auch mal die komplette Oberfläche in Fabric dazu.

Microsoft Fabric macht IoT ganz einfach: dank KQL! 16.06.2023

Das Beste am neuen Microsoft Fabric ist ja, dass es in der beliebten Oberfläche von Power BI den Nutzern ganz einfach ermöglicht, auch Anwendungen mal zu nutzen, die man früher erst aufwändig bei der IT beantragen musste! Ein großer Gewinner davon könnte Kusto sein, die spezielle Datenbank für Echtzeit-Daten, die in Azure einzeln als "Azure Data Explorer" oder ADX erhältlich ist. Sie kann nur eine Sache, aber die richtig, richtig gut: Logging-Informationen in Echtzeit einspeichern und auswerten! Das ist natürlich super für Daten, die von IoT-Geräten gesendet werden, aber eigentlich auch für alle anderen Formen von Protokoll-Daten, die nicht mehr verändert werden sollen. Und man lernt in diesem Video auch eine neue Abfragesprache kennen, nämlich KQL; die Kusto Query Language!

Scripting mit Spark in Microsoft Fabric 09.06.2023

Microsoft Analytics enthält schon immer viele Werkzeuge für die Datentransformation, und die meisten davon locken durch eine simple grafische Oberfläche. Typisch Microsoft! Aber unverändert wird in vielen Projekten sehr viel mit Skripten gearbeitet, es wird fleißig textbasiert programmiert! Auch das neue Microsoft Fabric enthält Notebooks, in denen man - mit meistens mit Python - richtig komfortabel entwickeln kann. Dieses Demo-Video zeigt mal, wie einfach es geht, und auch, wie effizient diese Verarbeitung auf einem Spark-Cluster ist! Also, liebe Power BI - Entwickler: keine Angst vor Skripten!

Power BI Berichte und Microsoft Fabric - blitzschnell dank Direct Lake-Abfragemodus! 02.06.2023

Power BI und das neue Microsoft Fabric sind sehr eng integriert, sie teilen sich dieselbe Oberfläche im Browser, beides ist "Software as a Service" und beides ist für Endnutzer sehr einfach zu bedienen. In diesem demo-reichen Video zeige ich, wie man auf Daten, die man frisch in den Data Lake geladen hat, total simpel ein Power BI-Modell und dann einen Bericht bauen kann; komplett mit eigenen Berechnungen und eigenen Zusatzdaten. Damit baut sich eine erwachsene Data Analytics-Lösung auf "Big Data" fast von selbst! Und man lernt auch noch, wie viele Fahrgäste typischerweise in einem New Yorker Taxi Platz haben.

Microsoft Fabric - ein erster Blick auf die neue Analyseplattform 26.05.2023

Die radikale Neuerung bei Data + Analytics von Microsoft, frisch von der Build-Konferenz, und alle reden davon: Microsoft Fabric! Es soll alles, was bisher da war, mit KI vereinen: Azure Synapse, Power BI, Spark-Cluster, Azure Data Explorer... OK, das war auch alles schon ganz schön kompliziert. Wie funktioniert diese "Vereinigung"? Ist das nur ein weiterer Marketing-Trick, oder steckt wirklich eine neue Technik dahinter? Dieses Demo-reiche Video zeigt das; und es vermittelt auch, wie leicht jeder selbst die ersten, praktischen Schritte gehen kann.

Wie SQL Server "serverlos" funktioniert 12.05.2023

Ein SQL Server ohne Server? Da stimmt doch was nicht! Doch, doch: auch der SQL Server macht mit bei einem der ganz großen Trends in der Cloud: Serverless Computing! In der Praxis ist das für uns Datenbanker vor allem eine bestimmte Form der Skalierung und Abrechnung bei der Azure SQL Datenbank. Dieses Video erklärt, worauf es bei Serverless Computing ankommt, wie man das einstellt und warum und wann man lieber die Finger davon lassen sollte...!

Weitere Videos finden Sie auf unserem YouTube Kanal

Zurück zu Aktuelle Videos